Kerasライブラリを使用していて、テンソルボードを使用して精度やその他の変数のグラフを印刷する場合は、以下の手順に従います。

ステップ1:以下のコマンドを使用してテンソルボードをインポートするようにkerasコールバックライブラリを初期化します

from keras.callbacks import TensorBoard

ステップ2:以下のコマンドをプログラムの「model.fit()」コマンドの直前に含めます。

tensor_board = TensorBoard(log_dir='./Graph', histogram_freq=0, write_graph=True, write_images=True)

注:「./graph」を使用してください。現在の作業ディレクトリにグラフフォルダを生成します。「/ graph」の使用は避けてください。

ステップ3:Tensorboardコールバックを「model.fit()」に含めます。サンプルを以下に示します。

model.fit(X_train,y_train, batch_size=batch_size, epochs=nb_epoch, verbose=1, validation_split=0.2,callbacks=[tensor_board])

ステップ4:コードを実行し、グラフフォルダが作業ディレクトリにあるかどうかを確認します。上記のコードが正しく機能する場合、作業ディレクトリに「Graph」フォルダがあります。

手順5:作業ディレクトリでターミナルを開き、以下のコマンドを入力します。

tensorboard --logdir ./Graph

ステップ6:Webブラウザーを開き、以下のアドレスを入力します。

http://localhost:6006

入力後、Tensorbaordページが開き、さまざまな変数のグラフを表示できます。

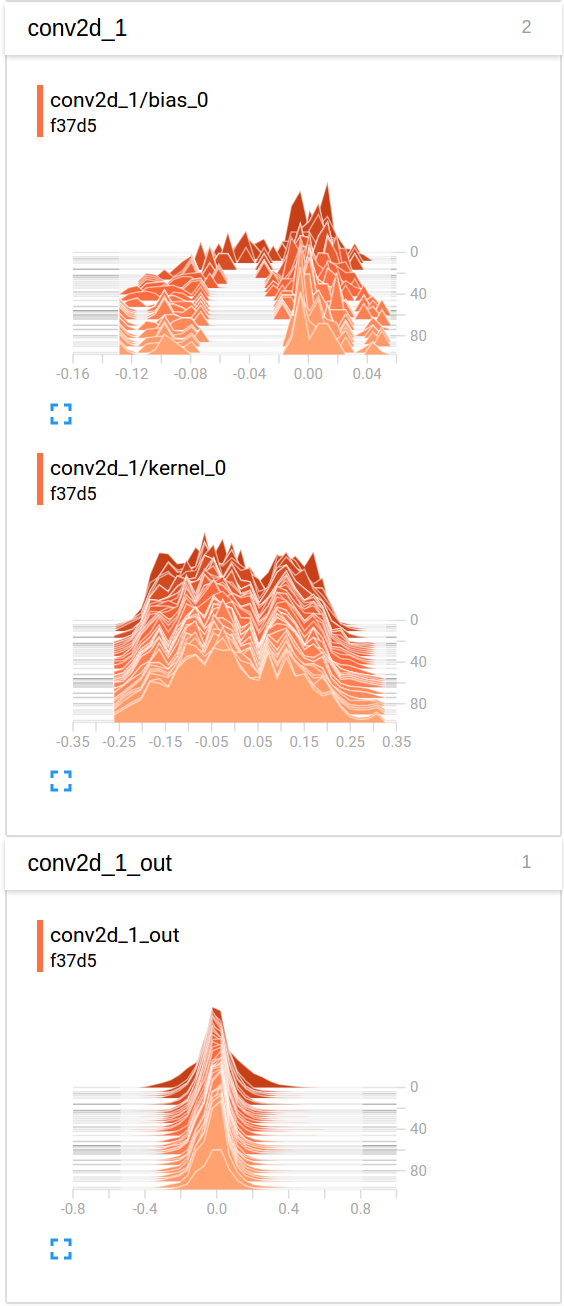

histogram_freqすることをお勧めします1。「histogram_freq:モデルのレイヤーのアクティベーションヒストグラムを計算する頻度(エポック単位)。0に設定すると、ヒストグラムは計算されません。」