どちらが先か:アルゴリズムのベンチマーク、機能の選択、パラメーターの調整?

回答:

機能エンジニアリングとしての機能選択を意味していると思います。私が通常従うプロセスは、一部の人々がそうであると私は見ています

- 特徴エンジニアリング

いくつかのアルゴリズムを試してください。通常は、機能でRandomForest、Gradient Boosted Trees、ニュートラルネットワーク、SVMなどの高性能なアルゴリズムを試してください。

2.1狭い範囲のパラメーターでグリッド検索などの簡単なパラメーター調整を行う

ステップ2の結果が満足のいくものでない場合は、ステップ1に戻ってさらに機能を生成するか、冗長な機能を削除して最適な機能を維持します。通常、この機能の選択はと呼ばれます。新機能のアイデアが不足している場合は、より多くのアルゴリズムを試してください。

結果が問題ない場合、または希望する結果に近い場合は、手順3に進みます。

- 広範なパラメーター調整

これを行う理由は、分類はすべて特徴エンジニアリングに関するものであり、コンピュータービジョンなどの特定の問題に合わせてカスタマイズされたディープラーニングなどの信じられないほど強力な分類子を知らない限りです。優れた機能を生成することが重要です。分類子の選択は重要ですが、重要ではありません。上記のすべての分類子は、パフォーマンスの点でかなり同等であり、ほとんどの場合、最良の分類子はそれらの1つであることがわかります。

パラメータのチューニングにより、パフォーマンスが大幅に向上する場合があります。しかし、優れた機能がなければ、チューニングはあまり役に立ちません。常にパラメータの調整を行う時間があることに留意してください。また、パラメータを大幅に調整する意味はありません。新しい機能を見つけて、すべてをやり直します。

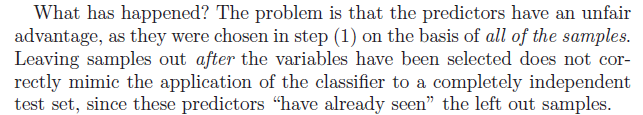

ちょっと私はあなたの質問を見た。最初に特徴選択を行い、次に交差検証を使用してモデルを調整するのは完全に間違っています。統計学習の要素とこのブログ投稿では、 CVメソッドは、モデルの構築がすべてCVループ内で行われた場合にのみバイアスされないことが明確に述べられています。したがって、パラメータ調整のためにCVループ内で機能選択を行います。これは、RのMLRパッケージのフィルターラッパーを使用して簡単に行うことができます。

CVメソッドは、モデルの構築がすべてCVループ内で行われた場合にのみバイアスされないことが明確に述べられています。したがって、パラメータ調整のためにCVループ内で機能選択を行います。これは、RのMLRパッケージのフィルターラッパーを使用して簡単に行うことができます。